- доступность

- Файл Robots.txt

- Мета-теги роботов

- HTTP коды состояния

- Карта сайта

- Веб-архитектура

- Flash или Javascript навигация

- Скорость Интернета

- indexibility

- Команда поиска по сайту:

- Соответствующие страницы

- Поиск бренда

- Google оштрафовал вас?

- 1. Убедитесь, что происходит

- 2. Определите причину

- Факторы позиционирования на месте

- URL-адрес

- Содержание

- Дублированный контент

- HTML-теги

- название

- Мета Описания

- Другие элементы HTML

- образность

- связи

- Наконец-то!

Когда в мои руки попадает новый SEO-проект, я чувствую непреодолимую потребность начать делать что-то, как только я вижу что-то, что может быть немного лучше, мне нужно это исправить, но это не очень хорошая идея, лучше всего успокоиться, сделать глубокий вдох и начать делать хорошее планирование, основанное на хорошем изучении Интернета и конкуренция ,

Прежде чем приступить к анализу или изучению, первое, что нужно сделать, - это просмотреть страницу, чтобы как можно глубже понять, с чем мы сталкиваемся.

Есть много шагов, которым нужно следовать при проведении анализа на месте, который идет к летописи истории, но может быть легко сгруппирован в четыре:

- доступность

- indexibility

- Вы были оштрафованы?

- Факторы позиционирования на месте

доступность

Если Google или пользователи не могут получить доступ к странице, она также может не существовать, что будет то же самое. Поэтому первое, на что нужно обратить внимание - это если наш сайт виден в глазах поисковых систем.

Файл Robots.txt

Файл robots.txt используется для предотвращения доступа и индексации определенными частями вашего веб-сайта поисковыми системами, хотя это очень полезно, может быть ситуация, когда мы блокируем доступ к нашему веб-сайту, не осознавая этого.

В этом крайнем случае файл robots.txt блокирует доступ ко всей сети:

Пользователь-агент: *

Disallow: /

Мы должны вручную убедиться, что файл robots.txt (обычно URL-адрес www.example.com/robots.txt ) не блокирует какую-либо важную часть нашего веб-сайта. Мы также можем сделать это через Инструменты Google для веб-мастеров ,

Мета-теги роботов

Мета-теги используются, чтобы сообщать роботам поисковых систем, могут ли они индексировать эту страницу, и переходить по ссылкам, которые она содержит. При анализе страницы мы должны проверить, есть ли метатег, который по ошибке блокирует доступ к роботам . Это пример того, как эти теги выглядят в коде HTML:

<meta name = »robots» content = »noindex, nofollow»>

HTTP коды состояния

Если какой-либо URL-адрес возвращает ошибку (ошибки 404, 502 и т. Д.), Пользователи и поисковые системы не смогут получить доступ к этой странице. На этом этапе вы должны определить все URL-адреса, которые возвращают ошибку, чтобы впоследствии исправить их.

Для идентификации этих URL я рекомендую использовать Кричащая лягушка , он быстро показывает вам статус всех URL-адресов вашей страницы, хотя в бесплатной версии он показывает только 500, даже если, если сеть не очень большая, это нам очень поможет. Также в Google Webmaster Tools мы видим это, но, на мой взгляд, это менее надежно.

Мы предпримем этот шаг, чтобы узнать, существует ли какое-либо перенаправление в Интернете, и если да, то является ли оно временным перенаправлением 302 (в этом случае мы бы преобразовали его в постоянное перенаправление 301) или это перманентное перенаправление 301, но перенаправления на страницу, которая не имела ничего общего с ним, а затем перенаправить его туда, где он должен быть.

Карта сайта

Карта сайта - это буквально карта для Google, с помощью которой мы гарантируем, что Google найдет все важные страницы нашего сайта. Есть несколько важных моментов, которые необходимо учитывать при работе с картой сайта:

- Если карта не соответствует протоколы для этого Google не будет обрабатывать его должным образом.

- Загружен ли файл Sitemap в Инструменты Google для веб-мастеров?

- Существуют ли веб-страницы, которые не отображаются в файле Sitemap? Если это так, вам придется обновить файл Sitemap.

- Если вы обнаружите в карте сайта какую-либо страницу, которую Google не проиндексировал, это означает, что вы не смогли их найти, убедитесь, что на нее указывает хотя бы одна ссылка в Интернете, и что мы не блокируем доступ по ошибке.

Веб-архитектура

Создайте схему всей сети, в которой вы можете легко увидеть уровни, которые у вас есть от дома до самой глубокой страницы, и сколько «кликов» вам нужно, чтобы их достичь. Он также ищет, есть ли на всех страницах хотя бы одна внутренняя ссылка, указывающая на них. Это можно легко проверить с помощью Открыть Site Explorer фильтрация ссылок только по внутренним. Это связано с тем, что у Google есть ограниченное время для отслеживания веб-сайта: чем меньше уровней вы должны перепрыгнуть, чтобы добраться до сути, тем лучше.

Flash или Javascript навигация

Хотя в последние годы он стал более интеллектуальным, когда дело доходит до чтения этих типов технологий, гораздо лучше не использовать их, чтобы избежать возможных проблем.

Чтобы проверить это, вам нужно всего лишь дважды перемещаться по Интернету: один с включенным Javascript, а другой с отключенным. использование Панель инструментов SEO для Firefox Нам будет намного легче.

Скорость Интернета

Хорошо известно, что одним из факторов увеличения показателя отказов является скорость загрузки страницы, но мы должны учитывать, что робот Google также имеет ограниченное время при просмотре нашей страницы , по крайней мере, Позже каждая страница загружается к большему количеству страниц, чтобы прибыть.

Вы можете использовать несколько инструментов, чтобы увидеть скорость загрузки в Интернете. Google Page Speed Он предлагает много данных о том, что замедляет загрузку в Интернете, а также советы от как улучшить скорость загрузки ,

Pingdom Это также дает нам более наглядную информацию о различных элементах, которые загружаются на нашем сайте, и время, которое требуется нашему браузеру для этого.

indexibility

Мы уже определили, к каким страницам могут обращаться поисковые системы, и теперь нам нужно определить, сколько из них фактически проиндексировано ими.

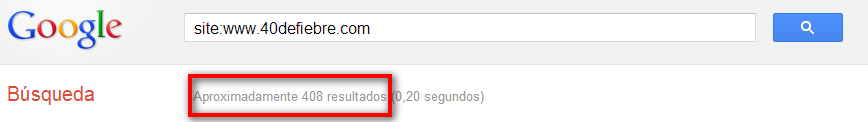

Команда поиска по сайту:

Google предлагает возможность поиска с помощью команды «site:». С помощью этой команды мы выполняем поиск в определенной сети, что дает нам очень приблизительное представление о количестве страниц, проиндексированных Google.

Это помогает нам сравнивать количество страниц, проиндексированных Google, с фактическим количеством страниц в Интернете, которое мы уже знаем по карте сайта и ранее просматривали в Интернете. 3 вещи могут произойти:

- Число в обоих очень похоже ... ХОРОШО!

- Число, которое отображается в поиске Google, ниже, что означает, что Google не индексирует многие страницы

- Число, которое появляется в поиске Google, выше, это почти всегда означает, что в Интернете есть проблема с дублированным контентом.

Во втором случае мы рассмотрим все точки доступа на случай, если с нами что-то случится. В третьем случае мы проверим, что на нашей странице нет дублирующегося контента, что я объясню позже.

Соответствующие страницы

Чтобы узнать, действительно ли страницы, которые лучше расположены, действительно важны, мы просто должны снова выполнить поиск с помощью команды «site:», логично было бы, чтобы сначала появился дом, а затем самые важные страницы в Интернете, если это не так. таким образом, мы должны выяснить, почему (мы увидим это ниже)

Поиск бренда

Зная, правильно ли расположены важные страницы, мы должны узнать, хорошо ли размещается сеть для поиска с собственным именем в сети.

Если веб-сайт появляется на верхних позициях, все в порядке, если веб-сайт нигде не появляется, у нас есть проблема: возможно, Google оштрафовал Интернет, пришло время выяснить.

Google оштрафовал вас?

Если вы остановились на этом этапе, возможно, у вас проблема с нашим другом Google. Относительно легко узнать, был ли вы полностью оштрафован Google, но лучше всего узнать даже малейшее наказание, которое Большой Брат смог нам дать.

Я уже говорил о как быстро определить штраф , но также имейте в виду, что потеря трафика также может быть связана с изменениями в алгоритме Google, поэтому вам нужно выполнить два шага, чтобы убедиться, что это действительно штраф:

1. Убедитесь, что происходит

Первое, что нужно сделать, - это поиск нашего бренда в Google, если мы нигде не появляемся, возможно, что это штраф, но также может быть и то, что мы блокируем доступ к Google в Интернете, если это так, мы должны продолжать снова шаги, которые я объяснил выше.

Как только мы проверим, что все хорошо, что касается нас, мы выполним поиск веб-адреса в Google (без команды site :) и посмотрим, все ли важные страницы появятся на первой странице; тогда мы будем искать URL-адреса каждого типа страниц, если бы это была электронная коммерция, это категория, подкатегория, продукт, производитель и т. д.

2. Определите причину

Если вы уверены, что какая-то часть Интернета наказывается, вы должны приступить к работе и выяснить причину. Это требует тщательного анализа любого внутреннего или внешнего фактора: один и тот же якорный текст во многих внутренних или внешних ссылках, вставка ключевых слов в содержание страниц, веб-ссылки сомнительного качества ... причин может быть много, просто нужно иметь терпение ,

Последний шаг будет исправить это и отправить повторное рассмотрение в Google из Инструментов Google для веб-мастеров, но это будет обсуждаться в других публикациях.

Факторы позиционирования на месте

Мы уже проанализировали доступность и индексируемость Интернета, теперь настал черед факторов, напрямую влияющих на позиционирование в Google . Этот шаг очень интересен, потому что именно там мы собираемся найти больше возможностей для улучшения вещей в сети.

URL-адрес

Для анализа URL-адресов страниц мы должны задать 5 вопросов:

- URL слишком длинный? Рекомендуется, чтобы вы не превышали 115 символов

- У URL есть соответствующие ключевые слова? Важно, чтобы URL-адрес описывал содержание страницы, поскольку он является воротами Google для Интернета.

- В URL слишком много параметров? Лучше всего было бы использовать статические URL-адреса, но если это невозможно, как это можно сделать в электронной торговле, мы избежим чрезмерного использования в дополнение к регистрации их в Инструментах Google для веб-мастеров ( конфигурация> параметры URL-адреса ).

- Используются ли «низкие бары» вместо дефисов? От Google рекомендуется использовать дефисы, чтобы отделить слова в URL

- Правильно ли вы перенаправили URL? Под этим я подразумеваю, если, например, перенаправляет с «не www» на «www» или перенаправляет с «.html» на «no .html» . Это позволит избежать проблем с дублированием контента

Содержание

Я думаю, что из Google было совершенно ясно, что контент короля , мы предлагаем ему хороший трон тогда.

Чтобы провести хороший анализ содержимого нашего веб-сайта, у нас есть несколько инструментов, но в конечном итоге самое полезное - использовать страницу, кэшированную Google, чтобы видеть только текстовую версию, таким образом, мы увидим, какой контент действительно читает Google и в каком порядке это устроено.

Во время анализа содержимого страниц мы зададим несколько вопросов, которые помогут нам в этом процессе:

- На странице достаточно контента? Не существует стандартного показателя того, сколько «достаточно», но, по крайней мере, оно должно содержать 300 слов

- Является ли содержание актуальным? Содержание должно быть полезным для читателя, просто спросив нас, будем ли мы это читать, мы дадим ответ.

- Содержатся ли в содержании важные ключевые слова? Появляются ли эти ключевые слова в первых абзацах?

- Есть ли наполнение контента ключевыми словами? Если в содержании страницы есть лишние ключевые слова, Google не будет счастлив

- Хорошо ли написано содержание? То есть есть ли орфографические ошибки, недостатки в синтаксисе, пунктуация?

- Легко ли читать контент? Если чтение не утомительно, все будет хорошо.

- Может ли Google прочитать текст страницы? Мы должны избегать того, чтобы текст был внутри Flash, изображений или JavaScript

- Хорошо ли распространяется контент? Этот SEOmoz сообщение очень хорошо объясняет, каким будет идеальное распределение

- Есть ли несколько страниц с одинаковыми ключевыми словами? Если это так, мы попадем в то, что называется «каннибализация ключевых слов», что нам нужно сделать, это добавить тег «rel = canonical» на самую важную страницу.

Лучший способ проверить все это, помимо терпения, - создать файл excel, в котором указывать для каждой страницы ключевые слова, на которых она сосредоточена, и все недостатки, которые мы видим на них, поэтому во время рассмотрите это для улучшения, у нас будет это намного легче.

Дублированный контент

Наличие дублированного контента означает, что для нескольких URL-адресов мы имеем одинаковый контент , это может быть внутренний или внешний дублированный контент. В другом посте я говорил о нескольких виды внутреннего дублированного контента и его решения ,

Чтобы обнаружить дублирующийся контент, мы видим, что вы просмотрели в Интернете возможные случаи дубликата контента, затем скопировали абзац текста и выполнили поиск в Google в [квадратных скобках] , это приведет не ко всем страницам так сильно. внутренние и внешние, которые содержат этот пункт. Инструменты, такие как Copyscape ,

HTML-теги

Не стоит недооценивать код страницы при проведении анализа, он содержит значительную часть наиболее важных факторов позиционирования.

Прежде чем мы начнем с конкретных моментов HTML-кода, мы должны убедиться, что он соответствует стандартам, W3C предлагает валидатор HTML, который покажет нам любой сбой кода.

название

Заголовок страницы, пожалуй, самый важный элемент. Это первое, что появляется в результатах в Google, и это то, что показывается, когда люди размещают ссылку в социальных сетях (кроме Twitter).

Чтобы проанализировать название, мы также будем следовать (конечно) ряд шагов:

- Название не должно превышать 70 символов, если не вырезано.

- Заголовок должен быть описательным по отношению к содержанию страницы

- Заголовок должен содержать важные ключевые слова, если это возможно в начале, если он не теряет логику

- Мы никогда не должны злоупотреблять ключевыми словами в заголовке, это вызовет недоверие пользователей, и Google думает, что мы пытаемся обмануть

Еще одна вещь, которую нужно иметь в виду, это где поставить «бренд», то есть название сети, обычно обычно ставится в конце, чтобы придать большее значение важным ключевым словам, отделяя их от имени сети скриптом. или вертикальная черта. Мы можем легко увидеть все заголовки страниц с Кричащая лягушка

Мета Описания

Хотя это и не фактор позиционирования, он значительно влияет на рейтинг кликов в результатах поиска.

Для мета-описания мы будем следовать тем же принципам, что и с заголовком, только длина этого не должна превышать 155 символов . Для заголовков и описаний мы должны избегать двуличия, это можно увидеть в Инструментах Google для веб-мастеров ( оптимизация> улучшения HTML ).

Другие элементы HTML

- Мета-ключевые слова - просто удалите их, если они существуют, Google не использует их вообще

- Ярлык «rel = canonical» - если есть страница, использующая этот ярлык, мы должны убедиться, что она переходит на правильную страницу. Как использовать тег «rel = canonical»

- Теги «rel = prev; rel = next »- если есть страницы, использующие эти теги, то же самое, убедитесь, что они указывают на правильные страницы. Как использовать теги «rel = prev; rel = next ».

- Метки H1, H2, H3 ... - Мы должны проанализировать, все ли страницы используют эти метки и содержат ли они ключевые слова, имеющие отношение к содержанию.

образность

При анализе изображений необходимо учитывать 3 фактора:

- Вес изображения - под этим я подразумеваю его вес в килобайтах, для этого необходимо проверить, сжаты ли они, имеют ли они redimensión и т. Д. Эта информация будет предоставлена нам Google Page Speed

- Тег «alt» - должен быть описательным в отношении изображения и содержимого, окружающего изображение.

- Название изображения - так же, как и в предыдущем пункте

связи

Очень важно проанализировать количество ссылок, как внешних, так и внутренних, и где они ссылаются, для этого (опять же, мы взвешиваем человека со списками), мы составим список наиболее важных факторов:

- Количество ссылок на страницу не должно превышать 100, и все страницы должны иметь одинаковое количество ссылок

- Внешние ссылки должны указывать на важные и релевантные сайты для содержания Интернета

- Якорный текст ссылок должен иметь важные ключевые слова, но мы не должны использовать одни и те же ключевые слова для всех ссылок.

- Не должно быть никаких ссылок, битых или указывающих на страницы с ошибками 404

- Могут быть ссылки, указывающие на страницы с перенаправлениями, в этом случае URL будет изменен на конечную целевую страницу

- Должно быть хорошее соотношение между ссылками « следовать» и « nofollow» , не все должны следовать или «все nofollow»

Вы также должны убедиться, что важные страницы получают ссылки с других важных страниц в Интернете и что на всех страницах в Интернете есть хотя бы одна ссылка, указывающая на них.

Наконец-то!

Следуя всем этим шагам, мы проведем SEO-анализ на месте любого веб-сайта, с помощью которого мы можем часами сидеть перед экраном, а затем оставлять его безупречным. Мне действительно нравится настаивать на том, что, независимо от того, сколько ссылок он создает, если эти ссылки указывают на страницы, которые заставляют нас плакать, они ничего не будут стоить.

Загружен ли файл Sitemap в Инструменты Google для веб-мастеров?Существуют ли веб-страницы, которые не отображаются в файле Sitemap?

Google оштрафовал вас?

В URL слишком много параметров?

Используются ли «низкие бары» вместо дефисов?

Содержатся ли в содержании важные ключевые слова?

Появляются ли эти ключевые слова в первых абзацах?

Есть ли наполнение контента ключевыми словами?

Легко ли читать контент?

Может ли Google прочитать текст страницы?